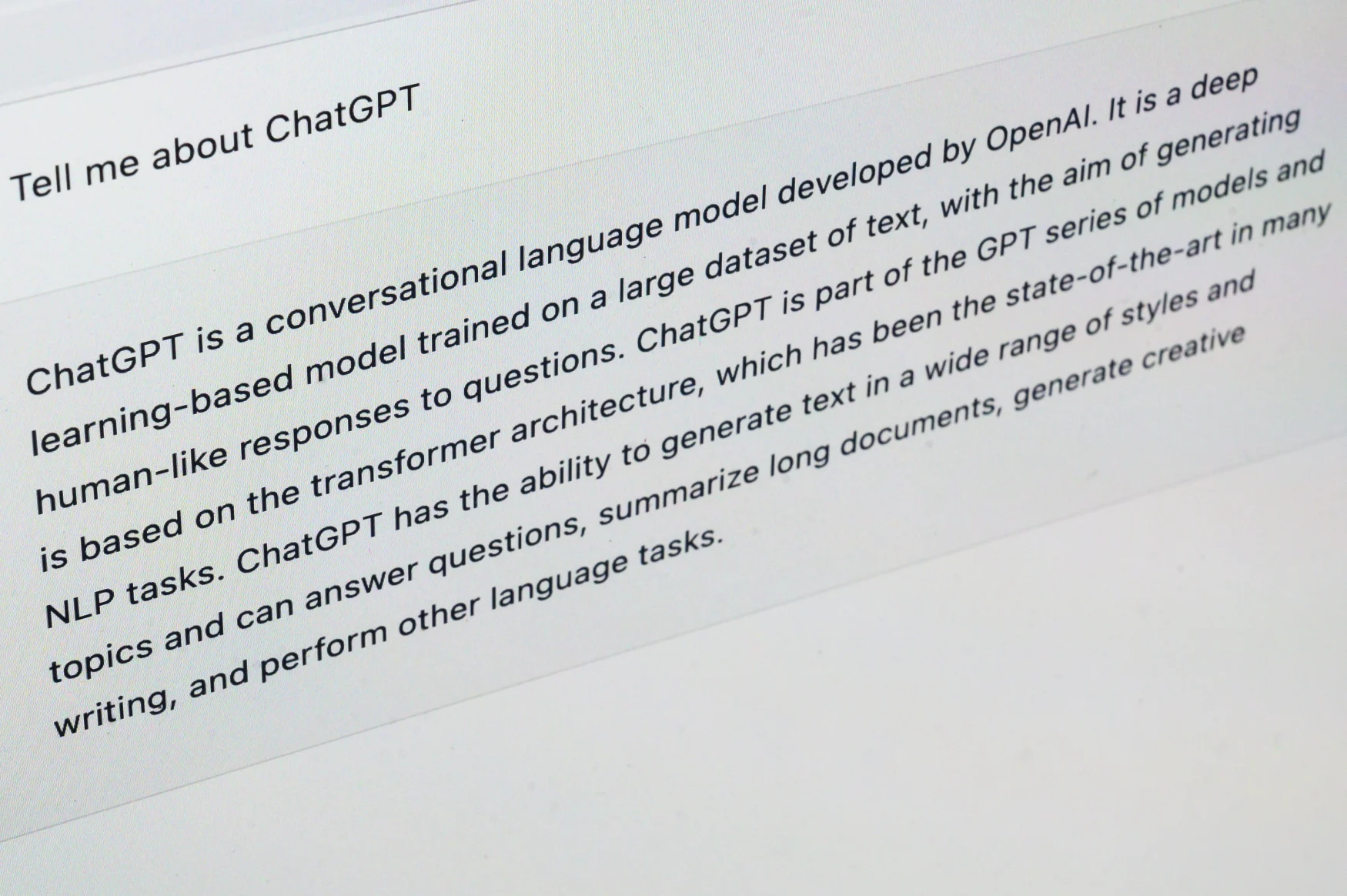

یا محصولی که سازندگان آن، در یک بازار تبلیغاتی، زمانی اعلام کردند که «خیلی خطرناک» برای عرضه برای عموم مردم، ChatGPT OpenAI این روزها ظاهراً همه جا است. سیستم همه کاره تولید متن خودکار (ATG) که قادر به خروجی نسخههایی است که تقریباً از آثار یک نویسنده انسانی قابل تشخیص نیست، به طور رسمی هنوز در نسخه بتا است اما قبلاً در دهها برنامه جدید استفاده شده است که برخی از آنها بسیار فراتر از نقشها هستند. ChatGPT در ابتدا برای آن در نظر گرفته شده بود – مانند آن زمان که یک پوسته عملیاتی لینوکس را شبیه سازی می کرد یا زمانی که امتحان ورودی مدرسه کسب و کار وارتون را قبول کرد.

تبلیغات در مورد ChatGPT به طور قابل درک زیاد است، با تعداد بی شماری از استارت آپ ها به دنبال مجوز دادن به این فناوری برای همه چیز از مکالمه با شخصیت های تاریخی گرفته تا صحبت با ادبیات تاریخی، از یادگیری زبان های دیگر گرفته تا ایجاد برنامه های ورزشی و بررسی رستوران ها هستند.

اما با این پیشرفتهای فنی، فرصتهای زیادی برای سوء استفاده و آسیب آشکار به وجود میآید. و اگر تلاشهای هولآمیز قبلی ما برای کنترل گسترش فناوریهای صوتی و ویدیویی عمیقفیک نشانهای بود، ما به طرز خطرناکی برای ویرانی که تولید خودکار اطلاعات نادرست در مقیاس و خودکار بر جامعه ما وارد میکند، آماده نیستیم.

نشانواره OpenAI روی صفحهنمایش تلفن و لوگوی مایکروسافت که روی صفحه نمایش در پسزمینه نمایش داده میشود، در این عکس تصویری که در 10 ژانویه 2023 در کراکوف، لهستان گرفته شده است، دیده میشود. (عکس توسط Jakub Porzycki/NurPhoto از طریق Getty Images)

OpenAI از زمان تاسیس خود در سال 2015 به عنوان یک غیر انتفاعی توسط سم آلتمن، پیتر تیل، رید هافمن، ایلان ماسک و تعدادی دیگر از افراد برجسته VC مشغول بوده است که همه در مجموع یک میلیارد دلار برای راه اندازی سازمان سرمایه گذاری کردند. . این سرمایهگذاری «نوعخواهانه» استدلال میکند که هوش مصنوعی «باید امتداد ارادههای فردی انسان باشد و با روحیه آزادی، تا حد امکان به طور گسترده و یکنواخت توزیع شود».

سال بعد، این شرکت اولین بتای عمومی خود را از پلتفرم آموزشی تقویتی OpenAI Gym منتشر کرد. ماسک در سال 2018 به دلیل تضاد منافع احتمالی با مالکیت تسلا از هیئت مدیره استعفا داد. سال 2019 به ویژه برای OpenAI پر حادثه بود. در آن سال، این شرکت یک شرکت تابعه انتفاعی «سرپوش دار» (OpenAI LP) به سازمان غیرانتفاعی اصلی (OpenAI Inc) تأسیس کرد، یک میلیارد دلار سرمایه اضافی از مایکروسافت دریافت کرد و اعلام کرد که قصد دارد مجوز تجاری محصولات خود را آغاز کند.

در سال 2020، OpenAI به طور رسمی GPT-3 را راهاندازی کرد، یک تولیدکننده متن که قادر به «خلاصهسازی اسناد قانونی، پیشنهاد پاسخ به سؤالات خدمات مشتری، پیشنهاد کد کامپیوتری [و] اجرای بازیهای نقشآفرینی مبتنی بر متن» بود. این شرکت API تجاری خود را در آن سال نیز منتشر کرد.

آرام ثابتی، بنیانگذار استارت آپ، پس از تعامل با سیستم، در آن زمان نوشت: «باید بگویم که من هول شدم. “این بسیار منسجم تر از هر سیستم زبان هوش مصنوعی است که من تا به حال امتحان کرده ام. تنها کاری که باید انجام دهید این است که یک درخواست بنویسید و متنی را که فکر می کند به طور قابل قبولی دنبال می کند اضافه می کند. من آن را برای نوشتن آهنگ ها، داستان ها، بیانیه های مطبوعاتی، تب های گیتار، مصاحبه ها، مقاله ها، دستورالعمل های فنی به دست آورده ام. خنده دار و ترسناک است. احساس می کنم آینده را دیده ام.»

سال 2021 شاهد انتشار DALL-E، یک تولید کننده متن به تصویر بود. و این شرکت در سال گذشته با انتشار ChatGPT، یک کلاینت چت مبتنی بر GPT-3.5، آخرین و فعلی تکرار GPT، دوباره سرفصل خبرها شد. در ژانویه 2023، مایکروسافت و OpenAI از تعمیق همکاری تحقیقاتی خود با سرمایهگذاری مداوم چند ساله و چند میلیارد دلاری خبر دادند.

دکتر برندی نونک، مدیر آزمایشگاه سیاست گذاری CITRIS و دانشیار تحقیقات سیاست فناوری در UC برکلی، به Engadget گفت: “من فکر می کنم این کار در بیرون ریختن متنی که قابل قبول است کار بسیار خوبی انجام می دهد.” «احساس میکند که واقعاً کسی آن را نوشته است. من خودم در واقع از آن برای غلبه بر یک نویسنده استفاده کردهام، فقط به این فکر میکنم که چگونه در بحثی که میخواهم مطرح کنم جریان دارم، بنابراین آن را مفید دیدم.»

گفته میشود، Nonnecke نمیتواند عادت سرسختانه سیستم برای تولید ادعاهای نادرست را پشت سر بگذارد. او افزود: «این مقاله به مقالاتی اشاره خواهد کرد که وجود ندارند. در حال حاضر، در این مرحله، واقع بینانه است، اما هنوز راه زیادی در پیش است.»

هوش مصنوعی مولد چیست؟

OpenAI تنها بازیکن بازی ATG نیست. هوش مصنوعی مولد (یا به طور خلاصه، gen-AI) تمرین استفاده از الگوریتمهای یادگیری ماشینی برای تولید محتوای جدید – خواه متن، تصویر، صدا یا ویدیو باشد – بر اساس مجموعه آموزشی از پایگاههای داده نمونه برچسبگذاری شده است. این یک رژیم آموزشی تقویتی استاندارد بدون نظارت شما است، که مشابه آن آلفاگو گوگل، موتورهای توصیه آهنگ و ویدیو در سراسر اینترنت و همچنین سیستمهای کمک راننده خودرو را آموزش دادهاند. البته در حالی که مدلهایی مانند Stability AI’s Stable Diffusion یا Google’s Imagen برای تبدیل الگوهای رزولوشن بالاتر از نقاط تصادفی به تصاویر آموزش دیدهاند، ATGهایی مانند ChatGPT، متن را ریمیکس میکنند.

حکیمان از داده های آموزشی خود بیرون کشیدند تا به طور مشکوکی واقع گرایانه، هرچند اغلب پیاده، نثر را ارائه دهند.

دکتر پیتر کراپ، استاد مطالعات فیلم و رسانه در دانشگاه کالیفرنیا، ایروین، به Engadget گفت: «آنها بر روی مقدار بسیار زیادی از ورودی آموزش دیده اند. «آنچه نتایج کم و بیش … میانگین آن ورودی است. این هرگز ما را با استثنایی یا خاص بودن، زیبا یا ماهر بودن تحت تاثیر قرار نمی دهد. این همیشه به نوعی شایسته خواهد بود – تا جایی که همه ما در مجموع تا حدودی در استفاده از زبان برای بیان خود صلاحیت داریم.”

هوش مصنوعی مولد در حال حاضر یک تجارت بزرگ است. در حالی که وقایع پر زرق و برق مانند سازنده Stable Diffusion به دلیل خراش دادن داده های آموزشی از Meta یا ChatGPT که توانسته راه خود را به دانشکده پزشکی باز کند (بله، علاوه بر وارتون) مورد شکایت قرار می گیرد، شرکت های Fortune 500 مانند NVIDIA، Facebook، Amazon Web Services، IBM و گوگل همه بی سر و صدا از Gen-AI برای منافع تجاری خود استفاده می کنند. آنها از آن در بسیاری از برنامه ها استفاده می کنند، از بهبود نتایج موتورهای جستجو و پیشنهاد کدهای کامپیوتری گرفته تا نوشتن محتوای بازاریابی و تبلیغات.

راز موفقیت ChatGPT

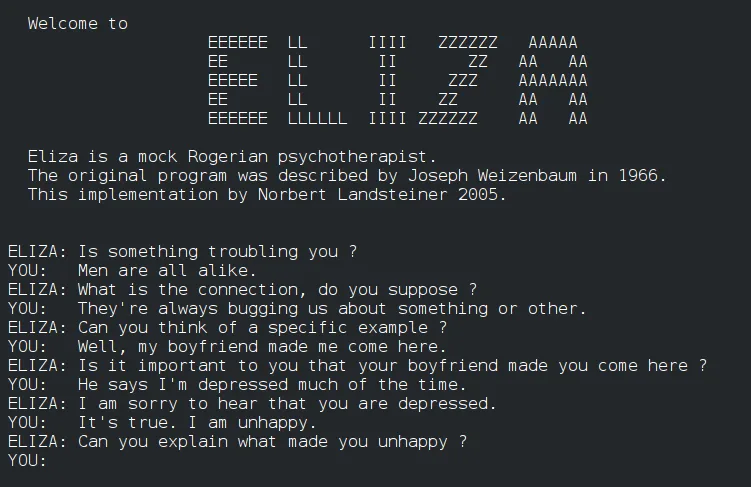

همانطور که دکتر کراپ اشاره میکند، تلاشها برای واداشتن ماشینها برای برقراری ارتباط با ما، همانطور که با افراد دیگر انجام میدهیم، در دهههای 1960 و 1970 آغاز شد و زبانشناسان جزو اولین پذیرندگان بودند. او توضیح داد: “آنها متوجه شدند که برخی از مکالمات را می توان به گونه ای الگوبرداری کرد که کم و بیش خودکفا باشند.” “اگر بتوانم با یک درمانگر معمولی کلیشه ای صحبت کنم، به این معنی است که می توانم کامپیوتر را طوری برنامه ریزی کنم که به عنوان درمانگر عمل کند.” به این ترتیب الیزا تبدیل به یک تخم مرغ عید پاک NLP شد که در Emacs، ویرایشگر متن محبوب لینوکس پنهان شده بود.

امروز، ما از نوادگان فناوری آن تلاشهای اولیه استفاده میکنیم تا منوهای رستورانهای شیک را برایمان ترجمه کنیم، به عنوان دستیار دیجیتالی در تلفنهایمان خدمت کنیم و بهعنوان نماینده خدمات مشتری با ما چت کنیم. با این حال، مشکل این است که برای اینکه یک هوش مصنوعی بتواند هر یک از این عملکردها را انجام دهد، باید به طور ویژه برای انجام آن یک کار خاص آموزش دیده باشد. ما هنوز سالها با هوش مصنوعی عمومی کاربردی فاصله داریم، اما بخشی از قابلیت چشمگیر ChatGPT ناشی از توانایی آن در نوشتن شعر متوسط است که میتواند مجموعهای از شرایط خدمات جعلی را برای وبسایت Truth Social به صدای دونالد ترامپ بدون نیاز به آموزش تخصصی بین این دو.

این انعطاف پذیری ساده امکان پذیر است زیرا ChatGPT در هسته خود یک ربات چت است. این اولین و مهمتر از همه برای تقلید دقیق از یک انسان مکالمه طراحی شده است، که در واقع در Reddit به مدت یک هفته در سال 2020 قبل از انتشار انجام داد. این با استفاده از روشهای یادگیری نظارتشده آموزش داده شد که در آن مربیان انسانی ابتدا هر دو طرف یک مکالمه را به مدل تغذیه میکردند – هم آنچه کاربر انسانی و هم عامل هوش مصنوعی قرار بود بگویند. ChatGPT با داشتن اصول اولیه در آن robomind، سپس اجازه داشت تا با انسانها گفتگو کند و پاسخهای آن پس از هر جلسه رتبهبندی شود. پاسخهای ذهنی بهتر در سیستم پاداش داخلی مدل امتیاز بالاتری کسب کردند و متعاقباً برای آنها بهینه شدند. این منجر به هوش مصنوعی با زبان نقرهای میشود، اما استعداد بررسی واقعیت «فقط بهطور مرتب ویکی را قبل از زنگ زدن بررسی میکند».

بخشی از موفقیت پرحاشیه ChatGPT – با به دست آوردن رکورد 100 میلیون کاربر فعال ماهانه تنها دو ماه پس از راهاندازی آن – مطمئناً میتواند به استراتژیهای بازاریابی جامد مانند سال 2020، ناتاشا آلن، شریک Foley & اشاره کرد. Lardner LLP، به Engadget گفت. “من فکر می کنم بخش دیگر این است که استفاده از آن چقدر آسان است. می دانید، یک فرد معمولی فقط می تواند برخی از کلمات را به کار ببندد و شما به آنجا بروید.

“افرادی که قبلاً به هوش مصنوعی علاقه ای نداشتند، واقعاً برایشان مهم نبود که چیست” اکنون شروع به توجه کرده اند. آلن استدلال می کند که سهولت استفاده از آن یک مزیت است و ChatGPT را به “چیزی جذاب و جالب برای افرادی تبدیل می کند که ممکن است به فناوری های هوش مصنوعی علاقه نداشته باشند.”

او اذعان کرد: “این یک ابزار بسیار قدرتمند است.” “فکر نمی کنم کامل باشد. من فکر می کنم که بدیهی است که برخی از خطاها وجود دارد، اما … 70 تا 80 درصد راه را برای شما به ارمغان می آورد.

آیا ChatGPT مایکروسافت، Taye مایکروسافت برای نسل جدید خواهد بود؟

اما در 20 تا 30 درصد آخر ممکن است بسیاری از موارد اشتباه پیش برود، زیرا ChatGPT در واقع نمی داند کلماتی که در حال ترکیب مجدد با جملات جدید هستند چه معنایی دارند، فقط روابط آماری بین آنها را درک می کند. سام آلتمن، مدیر اجرایی OpenAI، در ژوئیه 2020 در توییتی هشدار داد: «هیجان GPT-3 خیلی زیاد است. چشمگیر است اما هنوز هم دارای نقاط ضعف جدی است و گاهی اوقات اشتباهات بسیار احمقانه ای مرتکب می شود.

این اشتباهات «احمقانه» از مقایسههای بیمعنی مانند «مداد از توستر سنگینتر است» تا تعصب نژادپرستانهای که در چترباتهای گذشته مانند «تای» دیدهایم، متغیر است – خوب، واقعاً، اگر صادق باشیم، همه آنها تا به امروز هستند. برخی از پاسخهای ChatGPT حتی خود را تشویق میکنند

در میان کاربران خود، مجموعه ای از معضلات اخلاقی را ایجاد می کند (نه محدود به، آیا هوش مصنوعی باید تحقیقات علمی را تنظیم کند؟) هم برای شرکت و هم برای کل حوزه.

قابلیت ChatGPT برای استفاده نادرست بسیار زیاد است. قبلاً دیدهایم که از آن برای ایجاد بازاریابی هرزنامه و بدافزار کاربردی و نوشتن مقالات انگلیسی دبیرستانی استفاده میکند. اینها در مقایسه با آنچه ممکن است پس از بومی شدن این فناوری وجود داشته باشد، آزاردهنده کوچکی هستند.

Nonnecke گفت: “من نگران هستم زیرا اگر ویدیو و صدای جعلی عمیق داشته باشیم، آن را با ChatGPT گره بزنیم، جایی که می تواند چیزی شبیه به سبک صحبت کردن دیگران بنویسد.” این دو چیز در کنار هم فقط یک بشکه پودر برای اطلاعات نادرست متقاعد کننده هستند.

او ادامه داد: “من فکر می کنم بنزین روی آتش است، زیرا مردم به سبک خاصی می نویسند و صحبت می کنند.” و این گاهی اوقات می تواند به شما بگوید – اگر یک دیپ فیک می بینید و درست به نظر نمی رسد، روشی که آنها در مورد چیزی صحبت می کنند. در حال حاضر، GPT بسیار شبیه به افراد است، هر دو چگونه آنها می نویسند و صحبت می کنند. من فکر می کنم که این در واقع آسیب را تشدید می کند.»

نسل کنونی چتباتهای جعل هویت افراد مشهور از نظر تاریخی دقیق نیستند (مثلاً آواتار هنری فورد یهودیستیزانه نیست) اما پیشرفتهای آینده تقریباً میتواند خطوط بین واقعیت و محتوای ایجاد شده را پاک کند. Nonnecke با اشاره به اینکه کلاهبرداران قبلاً از نرمافزار شبیهسازی صوتی استفاده کردهاند تا خود را به عنوان یکی از بستگان علامت نشان دهند و از آنها پول کلاهبرداری کنند، گفت: “اولین راهی که قرار است از آن استفاده شود، بسیار محتمل است که کلاهبرداری کند.”

“بزرگترین چالش این است که چگونه به درستی به آن رسیدگی کنیم، زیرا این تقلبی های عمیق از بین رفته اند. شما در حال حاضر سردرگمی را دارید،” Nonnecke گفت. “گاهی اوقات از آن به عنوان سود سهام دروغگو یاد می شود: هیچ کس نمی داند که آیا درست است یا نه، پس به نوعی همه چیز دروغ است و به هیچ چیز نمی توان اعتماد کرد.”

باری، ایتالیا – 17 ژانویه: در این تصویر تصویری – برنامه Gpt Chat، نصب شده در تلفن هوشمند در 17 ژانویه 2023 در باری، ایتالیا. Chat GPT نوعی فناوری هوش مصنوعی است که از پردازش زبان طبیعی و یادگیری ماشینی برای ایجاد مکالمات شبیه انسان استفاده می کند. از آن در برنامه های مختلفی مانند چت ربات های خدمات مشتری، دستیاران مجازی و سیستم های خودکار پشتیبانی مشتری استفاده می شود. (عکس از دوناتو فاسانو/گتی ایماژ)

ChatGPT به دانشگاه می رود

ChatGPT در سراسر آکادمیک نیز در حال افزایش است. مولد متن بخش کتبی امتحان ورودی مدرسه بازرگانی وارتون را به همراه هر سه بخش آزمون مجوز پزشکی ایالات متحده گذرانده است. پاسخ سریع بوده است (همانطور که بیشتر درگیری های وحشت زده در پاسخ به فناوری های جدید معمولاً چنین است) اما بسیار متنوع است. سیستم مدارس دولتی شهر نیویورک رویکرد سنتی را در پیش گرفت و به طور بیاثری استفاده از برنامه را توسط دانشآموزان «ممنوع» کرد، در حالی که مربیانی مانند دکتر اتان مولیک، دانشیار دانشکده معتبر وارتون دانشگاه پنسیلوانیا، آن را در برنامههای درسی خود پذیرفتهاند.

مولیک گفت: “این یک تغییر ناگهانی بود، درست است؟ چیزهای خوب زیادی وجود دارد که ما باید آنها را متفاوت انجام دهیم، اما من فکر می کنم می توانیم مشکلات نحوه آموزش نوشتن به مردم در جهان با ChatGPT را حل کنیم.” NPR در ژانویه.

او افزود: «حقیقت این است که من احتمالاً نمیتوانستم جلوی آنها را بگیرم، حتی اگر این کار را نمیخواستم». در عوض، Mollick از دانشآموزانش میخواهد که از ChatGPT بهعنوان یک ایدهساز و سریع برای تکالیف مقالهشان استفاده کنند.

دکتر کراپ از UCI رویکرد مشابهی در پیش گرفته است. او توضیح داد: «در حال حاضر در چند کلاس تدریس میکنم که در آنها به راحتی میتوانم بگویم، «خوب، این تکلیف نوشتن ما است، بیایید ببینیم ChadGPT چه چیزی را ارائه میکند». من پنج روش مختلف را با اعلانهای مختلف یا اعلانهای جزئی انجام دادم و سپس از دانشآموزان خواستم روی این موضوع کار کنند که چگونه تشخیص دهیم که این توسط یک انسان نوشته نشده است و چه چیزی میتوانیم از آن بیاموزیم؟

آیا ChatGPT برای شغل نویسندگی شما آمده است؟

در ابتدای سال، سایت خبری فناوری CNET به دلیل استفاده از ATG با طراحی خاص خود برای تولید کل مقالههای توضیحدهنده مالی بلند مدت – در مجموع 75 مقاله از نوامبر 2022. ظاهراً این پستها به شدت توسط انسان بررسی شده بودند، منتشر شد. ویراستاران برای اطمینان از دقیق بودن خروجی خود، اگرچه بررسی های گذرا اشتباهات واقعی فاحشی را کشف کردند که CNET و شرکت مادر آن، Red Ventures را ملزم به صدور اصلاحات و به روز رسانی برای بیش از نیمی از مقالات می کرد.

رئیس BuzzFeed، Jonah Peretti، پس از دیدن پیامد فاجعهباری که CNET از این هجوم رایانهای تجربه میکرد، بلافاصله تصمیم گرفت که زبانش را نیز در خروجی بگذارد و اعلام کرد که نشریه او قصد دارد از Gen-AI برای ایجاد محتوای کم خطر مانند آزمونهای شخصیتی استفاده کند. .

این خبر تنها چند هفته پس از آن منتشر شد که BuzzFeed بخش قابل توجهی از اعضای تحریریه خود را به دلیل “شرایط چالش برانگیز بازار” اخراج کرد. نادیده گرفتن این تصادف سخت است، به ویژه با توجه به موجی از اخراجها که در حال حاضر بخشهای فناوری و رسانه را به این دلیل خاص به لرزه درآورده است، حتی در شرایطی که خود شرکتها از درآمد بیسابقه برخوردار هستند.

این اولین بار نیست که فناوری جدید کارگران فعلی را جابجا می کند. پل کروگمن، ستون نویس NYT به عنوان مثال به استخراج زغال سنگ اشاره می کند. این صنعت در طول قرن بیستم شاهد کاهش عظیم نیروی کار بود، نه به این دلیل که استفاده ما از زغال سنگ کاهش یافت، بلکه به این دلیل که فناوریهای معدن به اندازهای پیشرفت کردند که برای انجام همان مقدار کار به انسان کمتری نیاز بود. همین اثر در صنعت خودروسازی با روبات هایی که جایگزین افراد در خطوط مونتاژ می شوند دیده می شود.

کروگمن معتقد است: «پیشبینی دقیق اینکه هوش مصنوعی چگونه بر تقاضای کارکنان دانش تأثیر میگذارد دشوار است، زیرا بسته به صنعت و وظایف شغلی خاص، احتمالاً متفاوت خواهد بود. با این حال، ممکن است در برخی موارد، هوش مصنوعی و اتوماسیون بتواند برخی از وظایف مبتنی بر دانش را کارآمدتر از انسان ها انجام دهد و به طور بالقوه نیاز به برخی از کارکنان دانش را کاهش دهد.

با این حال، دکتر کراپ نگران نیست. من می بینم که برخی از روزنامه نگاران گفته اند، “نگران هستم.” شغل من قبلاً تحت تأثیر رسانه های دیجیتال و توزیع دیجیتال قرار گرفته است. اکنون نوع نوشتنی که من به خوبی انجام میدهم، میتواند با رایانه ارزانتر و سریعتر انجام شود.” ، نیاز – تمایل – به تشخیص آنچه در دیگران در مورد آنها انسانی است، داشته باشید.

[ChatGPT] چشمگیر است. بازی کردن با آن سرگرم کننده است، [اما] ما هنوز اینجا هستیم،» او افزود: «ما هنوز در حال خواندن هستیم، هنوز هم قرار است یک رابط اندازه انسانی برای مصرف انسان و برای لذت انسان باشد.»

نترسید که مطمئناً کسی ما را نجات خواهد داد

Nonnecke اطمینان دارد که دنبه های خرد کردن واقعیت اشتراکی ChatGPT در نهایت بسته می شود، چه توسط کنگره و چه خود صنعت در پاسخ به فشار عمومی. او به Engadget گفت: “من در واقع فکر می کنم که حمایت دو حزبی برای این کار وجود دارد، که در فضای هوش مصنوعی جالب است.” “و در حفظ حریم خصوصی داده ها، حفاظت از داده ها، ما تمایل داریم از حمایت دو حزبی برخوردار باشیم.”

او به تلاشهایی در سال 2022 اشاره میکند که توسط محقق ایمنی و تراز OpenAI، اسکات آرونسون، برای ایجاد واترمارک رمزنگاری شده به گونهای که کاربر نهایی بتواند به راحتی مواد تولید شده توسط رایانه را شناسایی کند، به عنوان نمونهای از تلاشهای صنعت برای خودتنظیمی اشاره میکند.

آرونسون در وبلاگ خود نوشت: «اساساً، هر زمان که GPT متن طولانی تولید میکند، ما میخواهیم یک سیگنال مخفی غیرقابل توجه در انتخاب کلمات آن وجود داشته باشد، که میتوانید بعداً برای اثبات اینکه، بله، این متن از GPT آمده است، استفاده کنید. ما میخواهیم گرفتن یک خروجی GPT و ارسال آن به گونهای که گویی از یک انسان آمده است، بسیار سختتر باشد. بدیهی است که این می تواند برای جلوگیری از سرقت علمی دانشگاهی مفید باشد، اما برای مثال، به عنوان مثال، تولید انبوه تبلیغات نیز مفید است.»

اثربخشی چنین حفاظتی باید دید. هیچ شفافیتی در نحوه تصمیم گیری آنها وجود ندارد که چه نوع درخواست هایی را مسدود یا مسدود کنند، که برای من بسیار نگران کننده است.