Slack مدلهای یادگیری ماشینی را روی پیامهای کاربر، فایلها و سایر محتواها بدون اجازه صریح آموزش میدهد. آموزش انصراف داده است، به این معنی که داده های خصوصی شما به طور پیش فرض زالو می شوند. بدتر شدن اوضاع، باید از مدیر Slack سازمان خود (منابع انسانی، فناوری اطلاعات و غیره) بخواهید که به شرکت ایمیل بزند تا از آن بخواهد متوقف شود. (شما نمیتوانید خودتان این کار را انجام دهید.) به بخش تاریک آموزش جدید هوش مصنوعی در جستجوی طلا خوش آمدید.

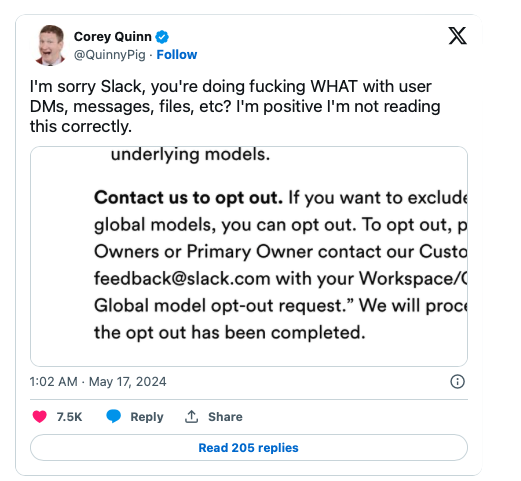

کوری کویین، یکی از مدیران گروه DuckBill، این سیاست را به صورت مبهم در اصول حریم خصوصی Slack مشاهده کرد و در مورد آن در X (از طریق PCMag) پست کرد. در این بخش آمده است (تاکید ما)، «برای توسعه مدلهای AI/ML، سیستمهای ما دادههای مشتری (مانند پیامها، محتوا و فایلها) ارسال شده به Slack و همچنین اطلاعات دیگر (از جمله اطلاعات استفاده) را همانطور که در خطمشی رازداری و تعریف شده است، تجزیه و تحلیل میکنند. در قرارداد مشتری شما.»

فرآیند انصراف شما را ملزم می کند تا تمام کارهایی را که برای محافظت از داده های خود انجام دهید، انجام دهید. طبق اعلامیه حفظ حریم خصوصی، «برای انصراف، لطفاً از صاحبان سازمان یا Workspace یا مالک اصلی خود بخواهید با تیم تجربه مشتری ما در feedback@slack.com با نشانی اینترنتی Workspace/Org و خط موضوع «درخواست انصراف مدل Slack Global» تماس بگیرند. ما درخواست شما را پردازش خواهیم کرد و پس از تکمیل انصراف پاسخ خواهیم داد.

این شرکت به پیام کوین در X پاسخ داد: «برای شفافسازی، Slack مدلهای یادگیری ماشینی در سطح پلتفرم برای مواردی مانند توصیههای کانال و ایموجی و نتایج جستجو دارد. و بله، مشتریان میتوانند دادههای خود را از کمک به آموزش مدلهای ML (غیر مولد) حذف کنند.»

مدتها پیش که شرکت متعلق به Salesforce این موضوع را در شرایط خود پنهان کرد، مشخص نیست. در بهترین حالت، این گمراهکننده است که بگوییم مشتریان میتوانند زمانی که «مشتریان» کارکنانی را که در یک سازمان کار میکنند، انصراف دهند. آنها باید از کسانی که دسترسی Slack را در کسب و کارشان مدیریت می کنند بخواهند که این کار را انجام دهد – و من امیدوارم که آنها متعهد شوند.

تناقضات در سیاست های حفظ حریم خصوصی Slack به سردرگمی اضافه می کند. در یکی از بخشها آمده است: «هنگام توسعه مدلهای Al/ML یا تجزیه و تحلیل دادههای مشتری، Slack نمیتواند به محتوای اصلی دسترسی پیدا کند. ما اقدامات فنی مختلفی برای جلوگیری از این اتفاق داریم.» با این حال، سیاست آموزش مدل یادگیری ماشینی ظاهراً با این بیانیه در تضاد است و جای زیادی برای سردرگمی باقی می گذارد.

علاوه بر این، صفحه وب Slack برای ابزارهای هوش مصنوعی مولد ممتاز خود بازاریابی میکند: «بدون نگرانی کار کنید. داده های شما داده های شما هستند. ما از آن برای آموزش Slack AI استفاده نمی کنیم. همه چیز بر روی زیرساخت امن Slack اجرا میشود و همان استانداردهای انطباق با خود Slack را دارد.

در این مورد، این شرکت از ابزارهای هوش مصنوعی مولد ممتاز خود صحبت میکند، جدا از مدلهای یادگیری ماشینی که بدون اجازه صریح در آن آموزش میدهد. با این حال، همانطور که PCMag اشاره میکند، این که تمام دادههای شما از آموزش هوش مصنوعی در امان هستند، در بهترین حالت، یک بیانیه بسیار گمراهکننده است، زمانی که ظاهراً شرکت باید مدلهای هوش مصنوعی را انتخاب کند و آن بیانیه را پوشش دهد.

Engadget سعی کرد از طریق چندین کانال با Slack تماس بگیرد اما در زمان انتشار پاسخی دریافت نکرد. اگر پاسخی شنیدیم، این داستان را بهروزرسانی میکنیم.