در تابستان 2023، OpenAI یک تیم “Superalignment” ایجاد کرد که هدف آن هدایت و کنترل سیستم های هوش مصنوعی آینده بود که می توانند آنقدر قدرتمند باشند که منجر به انقراض انسان شوند. کمتر از یک سال بعد، آن تیم مرده است.

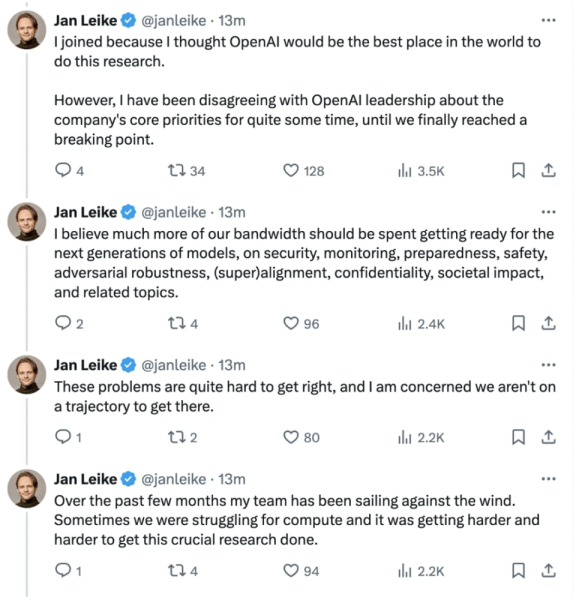

OpenAI به بلومبرگ گفت که این شرکت “در حال ادغام گروه عمیق تر در تلاش های تحقیقاتی خود برای کمک به شرکت در دستیابی به اهداف ایمنی خود است.” اما مجموعهای از توییتهای یان لیکه، یکی از رهبران تیم که اخیراً استعفا داد، تنشهای داخلی بین تیم ایمنی و شرکت بزرگتر را فاش کرد.

در بیانیه ای که در روز جمعه در X منتشر شد، لیک گفت که تیم Superalignment برای بدست آوردن منابع برای انجام تحقیقات مبارزه کرده است. لیک نوشت: «ساخت ماشینهای هوشمندتر از انسان، یک تلاش ذاتی خطرناک است. “OpenAI مسئولیت بزرگی را از طرف تمام بشریت بر عهده دارد. اما در طول سالهای گذشته، فرهنگ ایمنی و فرآیندها به سمت محصولات براق رفته است. OpenAI بلافاصله به درخواست نظر از طرف Engadget پاسخ نداد.

ترک Leike در اوایل این هفته چند ساعت پس از آن صورت گرفت که Sutskevar دانشمند ارشد OpenAI اعلام کرد که شرکت را ترک می کند. Sutskevar نه تنها یکی از رهبران تیم Superalignment بود، بلکه به تأسیس شرکت نیز کمک کرد. این حرکت سوتسکوار شش ماه پس از آن صورت گرفت که او در تصمیمی برای اخراج سم آلتمن مدیرعامل شرکت به دلیل نگرانی از اینکه آلتمن به طور مداوم با هیئت مدیره صادق نبوده بود، دست داشت. برکناری بسیار کوتاه آلتمن باعث یک شورش داخلی در شرکت شد و تقریباً 800 کارمند نامه ای را امضا کردند که در آن تهدید کردند در صورت عدم اعاده مجدد آلتمن از کار کنار می روند. پنج روز بعد، آلتمن پس از امضای نامهای مبنی بر پشیمانی از اقدامات خود، آلتمن به عنوان مدیر عامل OpenAI بازگشت.

هنگامی که OpenAI از ایجاد تیم Superalignment خبر داد، گفت که 20 درصد از قدرت رایانه خود را در چهار سال آینده به حل مشکل کنترل سیستم های هوش مصنوعی قدرتمند آینده اختصاص خواهد داد. این شرکت در آن زمان نوشت: «[به دست آوردن] این حق برای دستیابی به مأموریت ما حیاتی است. در X، Leike نوشت که تیم Superalignment برای انجام محاسبات “در حال مبارزه است و انجام تحقیقات مهم در مورد ایمنی هوش مصنوعی سخت تر و سخت تر می شود”. او نوشت: «در چند ماه گذشته تیم من برخلاف باد حرکت کرده است» و افزود که با رهبری OpenAI بر سر اختلاف نظر در مورد اولویتهای اصلی شرکت به «نقطه شکست» رسیده است.

در چند ماه گذشته، جدایی های بیشتری از تیم سوپرالاینمنت صورت گرفته است. طبق گزارش ها، در ماه آوریل، OpenAI دو محقق به نام های لئوپولد اشنبرنر و پاول ایزمایلوف را به اتهام افشای اطلاعات اخراج کرد.

OpenAI به بلومبرگ گفت که تلاشهای ایمنی آینده آن توسط جان شولمن، یکی دیگر از بنیانگذاران، که تحقیقاتش بر روی مدلهای زبانی بزرگ تمرکز دارد، رهبری خواهد شد. Jakub Pachocki، مدیری که توسعه GPT-4 – یکی از مدلهای زبان بزرگ پرچمدار OpenAI – را رهبری میکرد، جایگزین Sutskevar به عنوان دانشمند ارشد خواهد شد.

Superalignment تنها تیمی در OpenAI نبود که بر ایمنی هوش مصنوعی متمرکز بود. در ماه اکتبر، این شرکت یک تیم کاملاً جدید “آمادگی” را برای جلوگیری از “خطرات فاجعه بار” احتمالی سیستم های هوش مصنوعی از جمله مسائل امنیت سایبری و تهدیدات شیمیایی، هسته ای و بیولوژیکی راه اندازی کرد.